- Регистрация

- 07.05.2015

- Сообщения

- 2 184

- Благодарностей

- 2 197

- Баллы

- 113

#1.1. Вкратце описание схемы: мне не нужен доступ к вашему сайту/хостингу для добавления его в Search Console (Гугл-панель вебмастера). Я добавляю туда свои сайты, создаю на них отдельные страницы, которые редиректят на ваши страницы. Я аддурлю свои страницы, а гугл переходит с них сразу на ваши, как будто это я ваши аддурлил.

При аддурле 1 страницы в индекс обычно попадет сама страница + все страницы с ее домена, на которые эта страница ссылается!

Но ключевое слово здесь в «обычно». Я НЕ даю гарантий на добавления сайта в индекс, ибо их и никакой сервис не дает. У себя замечаю, что часть доров (на фриномах свежереги, купить можно в отдельной теме) могут только на пару страниц в индекс войти, или вообще не войти, и таких где-то 10%. Повторный аддурл обычно слабо помогает. Наверное, если гуглу сайт с первого раза не понравился чем-то, то он его сразу в черный список заносит. Так что готовьтесь что результат будет не идеален.

Загонял (и загоняю) свои дорвеи таким методом еще до того, как закрылся официальный «Google AddURL». Практиковал немного как услугу некоторым покупателям фрином-доменов. Сейчас решил создать паблик тему. Все организовано на шаблонах Zennoposter со своими хитростями. Метод несложный, основа давно на форумах палилась. Есть даже хороший сервис с той же схемой, который я в своих топиках по фриномах предлагаю для быстрой индексации новичкам: bulkaddurl.com. С моими оборотами я ему не конкурент, ибо у меня просто услуга с ручным оформлением заказа, без сайта, детализированных отчетов, планировщика и других фишек. Просто у меня дешевле.

Если покупатель выбирал «1) Ссылки на карту сайта в *.xml формате.» и на сайте всего пару тысяч страниц, то в 90% случаев гугл быстро все обработает: в первый же день добавит в индекс пару сотен страниц, а на второй….третий день все остальное. Потом в течении ближайших пару дней он начнет «выплевывать» понемножку те страницы что ему не понравились, индекс начнет прыгать, и так пока не устаканится на какой-то отметке. Здесь уже все зависит от качества сайта и настроения гугла.

Также я пришел к выводу что схема идеально работает для свежих страниц сайтов (сам сайт может быть как «свежерег», так и «дроп»). Главное, чтобы гугл еще не был на новых страницах. То есть вылетевшие из индекса старые страницы таким методом неохотно повторно лезут.

Если покупатель выбирал «1) Ссылки на карту сайта в *.xml формате.» и на сайте всего пару тысяч страниц, то в 90% случаев гугл быстро все обработает: в первый же день добавит в индекс пару сотен страниц, а на второй….третий день все остальное. Потом в течении ближайших пару дней он начнет «выплевывать» понемножку те страницы что ему не понравились, индекс начнет прыгать, и так пока не устаканится на какой-то отметке. Здесь уже все зависит от качества сайта и настроения гугла.

Также я пришел к выводу что схема идеально работает для свежих страниц сайтов (сам сайт может быть как «свежерег», так и «дроп»). Главное, чтобы гугл еще не был на новых страницах. То есть вылетевшие из индекса старые страницы таким методом неохотно повторно лезут.

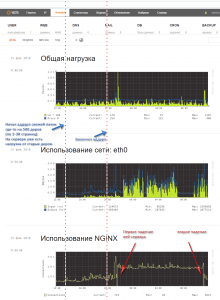

#1.3. Учитывая, как быстро приходит гугл-бот, то крупные заказы лучше растягивайте на пару дней, а то сервак может упасть от внезапной нагрузки. Вот прям как у меня на скриншоте:

Например у вас дешевый VPS за 4$, на нем 1000 доменов по 2..3К страниц в каждом. Вы заливаете на них доры и предоставляете мне для аддурла список Sitemap с этих доров. Я аддурлю все это за пару часов. Гугл в тот же день заходит на все ети карты и в ближайшие часы начинает активно ходить по ссылкам из карт, создавая неплохую нагрузку на сервер (~1000 потоков с пиками до 5000). В 50% сервер «упадет» на пиковых нагрузках, если он на стандартных настройках и не оптимизирован. Так что на дешевом железе либо следите за работой сервера и перегружайте его в случае падения, либо заказывайте услугу с примечанием «растянуть аддурл на 2..3 дня», чтобы избежать резких наплывов ботов. Иначе в случае недоступности сайтов эффекта от услуги будет мало.

У меня на скриншоте више панелька VestaCP + CentOS7. После падения сервер в течении трех минут восстанавливает службу NGINX, и сайты работают опять. По умолчанию такого нет, делается через костыли с помощью Monit. Основу взял с этих постов:

https://forum.vestacp.com/viewtopic.php?f=28&t=8733&hilit=monit&sid=357e275b39f352928abd7a2ed8e6ad1e#p28869

Отсюда брал инфу только с первого раздела о самой инсталляции Monit:

https://forum.vestacp.com/viewtopic.php?f=11&t=17576

То есть фактически для установки только пару строк вводим:

После установки только в главном файле конфиге «/etc/monitrc» прописал строки для слежения за NGINX (у меня там для экономии ресурсов связка без Апача, суто “Vesta + nginx + php-fpm”), хз насколько они правильные, но на деле все работает, и иногда даже письма шлет после перезапуска (в папку спам правда сразу  ). В коде меняете "vash_MAIL@gmail.com" на свою почту, и IP 180.24.9.180 на свой:

). В коде меняете "vash_MAIL@gmail.com" на свою почту, и IP 180.24.9.180 на свой:

У меня на скриншоте више панелька VestaCP + CentOS7. После падения сервер в течении трех минут восстанавливает службу NGINX, и сайты работают опять. По умолчанию такого нет, делается через костыли с помощью Monit. Основу взял с этих постов:

https://forum.vestacp.com/viewtopic.php?f=28&t=8733&hilit=monit&sid=357e275b39f352928abd7a2ed8e6ad1e#p28869

Отсюда брал инфу только с первого раздела о самой инсталляции Monit:

https://forum.vestacp.com/viewtopic.php?f=11&t=17576

То есть фактически для установки только пару строк вводим:

Код:

yum install epel-release

yum install monit

systemctl start monit

systemctl enable monit ). В коде меняете "vash_MAIL@gmail.com" на свою почту, и IP 180.24.9.180 на свой:

). В коде меняете "vash_MAIL@gmail.com" на свою почту, и IP 180.24.9.180 на свой:

Код:

set daemon 180

set logfile /var/log/monit.log

set logfile syslog facility log_daemon

set mailserver localhost

set alert vash_MAIL@gmail.com with mail-format {

from: monit@domain.com

subject: OVH8 - $SERVICE $EVENT at $DATE

message: Monit $ACTION $SERVICE at $DATE on $HOST: $DESCRIPTION.

ZA RABOTU!

}

## Nginx monitoring.

## Test the nginx service.

check process nginx with pidfile /var/run/nginx.pid

group nginx

start program = "/usr/bin/systemctl start nginx"

stop program = "/usr/bin/systemctl stop nginx"

restart program = "/usr/bin/systemctl restart nginx"

## Test port 80. Restart if the server is down.

if failed host 180.24.9.180 port 80 protocol http then restart

## If the restarts attempts fail then alert.

if 3 restarts within 5 cycles then timeout

alert vash_MAIL@gmail.com only on {timeout}#1.4. Список страниц для индексации сбрасываете мне списком в *.txt файле. Это могут быть разные варианты. Рекомендую рандомизировать, но чаще все же брать первый пункт:

Пример:

Это самый популярный метод, ибо гугл очень охотно обрабатывает такой формат. В индекс он саму карту обычно не добавляет, но добавляет почти все внутренние страницы, на которые ссылкаются урлы в карте.

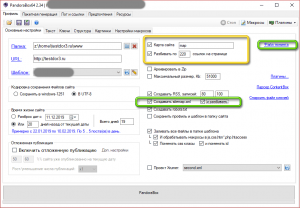

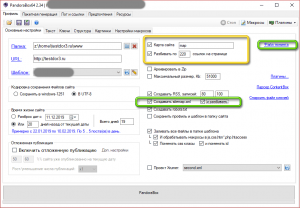

Вот только я бы не рекомендовал в одной карте делать больше 5….10К ссылок. Так как наблюдал что тогда медленнее гугл «кушает» ее. Лучше настройте в своем сайте/доргене разделение карты sitemap.xml на мелкие части, тогда активнее процесс добавления произойдет. На примере скриншота настроек доргена PandoraBox видно что надо поставить чекбокс (в зеленом прямоугольнике), и в настройках файла tuning.txt задать «SitemapSplitSize=5000».

Метод идеален для крупных сайтов. Ну и самый «экономный», так как за 1 раз аддурля просто урл на sitemap.xml можно загнать в индекс пару тысяч страниц, то есть фактически целый небольшой дорвей.

Код:

http://site1.tk/sitemap.xml

http://site2.com/sitemap-1.xml

http://site2.com/sitemap-2.xml

http://site2.com/sitemap-3.xmlВот только я бы не рекомендовал в одной карте делать больше 5….10К ссылок. Так как наблюдал что тогда медленнее гугл «кушает» ее. Лучше настройте в своем сайте/доргене разделение карты sitemap.xml на мелкие части, тогда активнее процесс добавления произойдет. На примере скриншота настроек доргена PandoraBox видно что надо поставить чекбокс (в зеленом прямоугольнике), и в настройках файла tuning.txt задать «SitemapSplitSize=5000».

Метод идеален для крупных сайтов. Ну и самый «экономный», так как за 1 раз аддурля просто урл на sitemap.xml можно загнать в индекс пару тысяч страниц, то есть фактически целый небольшой дорвей.

Код:

http://site1.tk/map1.html

http://site2.com/map1.php

http://site2.com/map2.php

http://site2.com/map2.phpКушает их Гугл почти так же хорошо как и sitemap.xml, только тут бы советовал ограничится 100….300 урлов на 1 странице карты. В итоге получается, что за 1 раз крупный сайт уже не загнать быстро. Но если гуглу сайт понравится, и внутрення перелинковка нормальная, то он понемножку сам будет кушать остальные страницы.

Код:

http://site1.tk/razdel1/

http://site2.com/razdel1.php

http://site2.com/razdel2.php

http://site3.com/razdel3-page1.html

Код:

http://site1.tk/post1.html

http://site2.com/post1.php

http://site2.com/post2.php#1.5. Условия формирования ссылок:

Ссылки должны быть в таком виде, в котором они отображаются в обычном браузере. То есть если у вас сайт открывается по httpS протоколу, с WWW-префиксом и в браузере урл карты сайта выглядит вот так:

Код:

https://www.site1.tk/sitemap.xml

Код:

// Так НЕПРАВИЛЬНО:

site1.tk/sitemap.xml

http://www.site1.tk/sitemap.xml

https://site1.tk/sitemap.xml#1.5.1 Требования к ссылкам (точнее к страницам на которые они ведут):

1. Страница должен нормально работать без ошибок (отвечать кодом 200).

2. Если это XML-карта, то она не должна содержать больше 2000 ссылок.

3. Если это обычная страница (HTML/PHP), то она должна иметь более-менее валидную верстку без критических ошибок и нормальный размер (а не здоровенная простыня текста\ссылок), чтобы гугл успел ее погрузить быстро с первого раза.

Если не соблюдать эти условия, то гугл часто ругается на ошибку индексирования.

#1.6. Как обстоит весь процесс:

1. Стучитесь по указанным контактам.

2. Запрашиваете реквизиты.

3. Оплачиваете.

4. Сбрасываете список ссылок для аддурла.

5. Я приблизительно укажу, когда начну\закончу добавление, учитывая пожелания покупателя.

5.1 Я просканирую ссылки на валидность своим ботом на Get-запросах в 1 поток. У него могут быть разные IP европейских дата-центров, но UserAgent как у гугла:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)6. В ближайшие минуты…часы после обработки заказа на сайт прийдет гугл-бот и начнет активно сканировать страницы. На крупных заказах это видно будет по логам и нагрузки хостинга.

7. Дожидаетесь первых признаков индексации (через пару дней...недель) и пишите хвалебный отзыв какой автор молодец

.

.#1.7. Контакты:

Telegram: orka13 (ссылка кликабельная, добавляйтесь по ней, а то могут быть мошенники с подобными никами)

Skype: orkanavtica

#1.8. Цены:

0.014 $ за 1 ссылку под аддурл. Или 0.007 $, если гоняете купленные у меня фриномы.

Минимальный заказ: 7$ (500 ссылок).

Принимаю: Webmomey WMZ, WMR (1:70), QIWI (1:70), Яндекс.Деньги (1:70).

Последнее редактирование:

Хорошо что хоть без тестя и зятя.

Хорошо что хоть без тестя и зятя.