- Регистрация

- 23.11.2022

- Сообщения

- 119

- Благодарностей

- 142

- Баллы

- 43

Написание блог-постов часто занимает много времени, особенно для веб-сайтов, которым нужны регулярные обновления. Чтобы упростить этот процесс, я попытался автоматизировать создание контента для блога. Моя цель заключалась в том, чтобы настроить систему, которая могла бы эффективно собирать информацию, генерировать новые посты и публиковать их с минимальным вмешательством человека.

Это исследование случая объясняет, как я использовал шаблоны ZennoPoster и такие инструменты, как ChatGPT, для автоматизации создания контента. Эксперимент подчеркнул как сильные стороны автоматизации, так и ограничения ИИ в создании качественного контента.

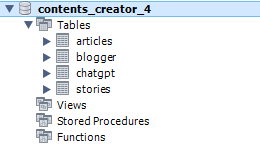

Чтобы обеспечить бесшовную работу всех шаблонов, я использовал базу данных MySQL для управления рабочим процессом. База данных служила центральной точкой для хранения критически важной информации, такой как завершенные статьи, активные аккаунты и опубликованные посты. Эта настройка позволила шаблонам работать вместе гладко, предотвращая повторение задач или пропуск шагов.

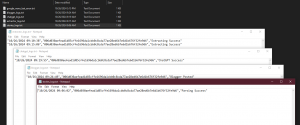

Чтобы обеспечить бесшовную работу всех шаблонов, я использовал базу данных MySQL для управления рабочим процессом. База данных служила центральной точкой для хранения критически важной информации, такой как завершенные статьи, активные аккаунты и опубликованные посты. Эта настройка позволила шаблонам работать вместе гладко, предотвращая повторение задач или пропуск шагов.  Я также внедрил систему логирования для записи всех действий, выполняемых каждым шаблоном, что позволило мне отслеживать прогресс и решать любые проблемы. Этот журнал был важен для устранения неполадок, особенно при переключении между разными аккаунтами ChatGPT или публикации статей на Blogger.

Я также внедрил систему логирования для записи всех действий, выполняемых каждым шаблоном, что позволило мне отслеживать прогресс и решать любые проблемы. Этот журнал был важен для устранения неполадок, особенно при переключении между разными аккаунтами ChatGPT или публикации статей на Blogger. Для достижения этой цели я создал четыре основных шаблона.

Шаблон Google News: Парсинг главных новостей

Первым шагом было сбор релевантной информации. Я разработал специализированный шаблон для сбора главных новостей из Google News в определенных категориях, таких как технологии, бизнес и спорт. Этот шаблон извлекал заголовки, аннотации и ссылки на каждую статью. Данные сохранялись в подпапках, организованных по категориям, при этом каждая история хранилась в базе данных, где ее ID был зашифрован с использованием SHA256. Связанные изображения загружались и сохранялись в папке "изображения".

Шаблон извлечения статей

После сбора новостных статей мне нужно было очистить их содержимое для дальнейшей обработки. Парсинг статей может быть сложным из-за разнообразных макетов и структур различных веб-сайтов. Чтобы упростить это, я использовал расширения браузера, такие как Just Read, чтобы удалить ненужные элементы, оставив только основную статью.

Шаблон извлекал только текст из каждой статьи, отбрасывая дополнительные элементы, такие как реклама, изображения и меню. Метаданные статьи хранились в базе данных, и каждый ID статьи преобразовывался в хэш SHA256 для упрощения отслеживания. Этот процесс помогал выявлять дублирующиеся истории; если ID статьи уже существовал в системе, это означало, что история уже была обработана. Этот метод экономил время и избегал избыточности.

Шаблон ChatGPT: Управление несколькими аккаунтами

Чтобы создать уникальный контент для блога, я использовал ChatGPT. Однако, учитывая ограничения по использованию, мне понадобилось несколько аккаунтов, чтобы сгенерировать достаточное количество контента для моего проекта. Поэтому я создал шаблон, который помогал управлять и переключаться между более чем 60 бесплатными аккаунтами ChatGPT.

Шаблон автоматически входил в аккаунты ChatGPT, чтобы генерировать контент из собранных статей. Если сессия заканчивалась или достигала предела использования, система переключалась на другой аккаунт и продолжала генерировать контент. Управление несколькими аккаунтами и автоматизация входа были простыми. Использование различных профилей позволяло быстро переключаться между аккаунтами, что помогало избежать задержек в создании контента.

Шаблон Blogger

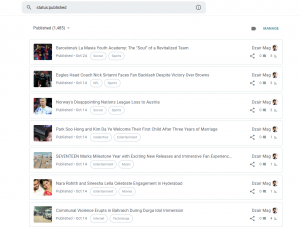

После того как ChatGPT создал контент, следующим шагом было автоматическое размещение статей на Blogger. Шаблон Blogger брал контент, сгенерированный ChatGPT, редактировал его, чтобы удалить ненужные элементы, и публиковал его. Он также добавлял все необходимые изображения и обеспечивал хороший внешний вид поста.

В процессе публикации шаблон автоматически уточнял вывод ChatGPT, чтобы сделать его более удобным для блога, удаляя любые ненужные инструкции или оговорки.

Результаты

Эксперимент оказался успешным в автоматизации всего процесса создания контента для блога. С этой системой я мог производить и публиковать множество статей с очень небольшими усилиями. Шаблоны эффективно интегрировались, а база данных способствовала плавным переходам между задачами.

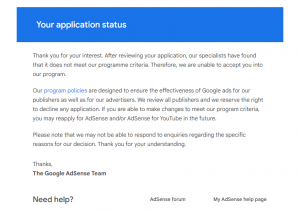

Эксперимент оказался успешным в автоматизации всего процесса создания контента для блога. С этой системой я мог производить и публиковать множество статей с очень небольшими усилиями. Шаблоны эффективно интегрировались, а база данных способствовала плавным переходам между задачами. Одной из проблем было обеспечение того, чтобы контент, созданный ИИ, соответствовал стандартам качества AdSense. Я попытался зарегистрироваться в Google AdSense с блогом, созданным с помощью этой системы, но моя заявка была отклонена из-за несоответствия их "политике контента". Это распространенная проблема с контентом, созданным ИИ, так как стандарты качества могут быть трудно соблюсти последовательно.

Хотя я настроил несколько аккаунтов ChatGPT для автоматической работы, мне пришлось продолжать вносить изменения со временем, чтобы избежать блокировок аккаунтов или ограничений из-за чрезмерного использования.

Writing blog posts often takes a lot of time, especially for websites that need regular updates. To make this easier, I tried automating the entire process of creating blog content. My aim was to set up a system that could efficiently collect information, generate new posts, and publish them with minimal manual intervention.

This case study explains how I used ZennoPoster templates and tools like ChatGPT to automate content creation. The experiment highlighted both the strengths of automation and the limitations of AI in generating quality content.

To ensure all templates worked seamlessly together, I used a MySQL database to manage the workflow. The database served as a central point to store critical information, such as which articles were completed, which accounts were active, and which posts had been published. This setup allowed the templates to work together smoothly, preventing task repetition or missed steps.

I also implemented a logging system to record all actions performed by each template, which allowed me to monitor progress and address any issues. This log was crucial for troubleshooting, especially when switching between different ChatGPT accounts or publishing articles on Blogger.

To accomplish this, I used four main templates:

Google News Template: Parsing Top Stories

The first step was collecting relevant information. I developed a specialized template to gather top news stories from Google News in specific categories, such as technology, business, and sports. This template extracted the titles, summaries, and links for each article. The data was saved into subfolders organized by category, with each story stored in a database where its ID was hashed using SHA256. Related images were downloaded and stored in an "images" folder.

Article Extractor Template

After collecting the news articles, I needed to clean up their content for further processing. Parsing articles can be challenging due to the diverse layouts and structures of different websites. To simplify this, I used browser extensions like Just Read to remove unnecessary elements, leaving only the main article.

The template extracted only the text from each article, discarding extra elements like ads, images, and menus. Article metadata was stored in the database, and each article ID was converted into a SHA256 hash to simplify tracking. This process helped identify duplicate stories; if an article ID already existed in the system, it meant that the story had already been parsed. This method saved time and avoided redundancy.

ChatGPT Template: Managing Multiple Accounts

To create unique content for the blog, I used ChatGPT. However, given the usage limits, I needed multiple accounts to generate sufficient content for my project. So, I built a template to help manage and switch between over 60 free ChatGPT accounts.

The template automatically logged into ChatGPT accounts to generate content from the gathered articles. If a session ended or hit a usage limit, the system would switch to another account and continue generating content. Managing multiple accounts and automating logins was easy. Using different profiles allowed quick switching between accounts, which helped avoid delays in content creation.

Blogger Template

After ChatGPT created the content, the next step was to automatically post the articles on Blogger. The Blogger template took the content generated by ChatGPT, edited it to remove unnecessary elements, and posted it. It also added any required images and ensured the post looked good.

During the posting process, the template automatically refined ChatGPT’s output to make it more blog-friendly by removing any unnecessary instructions or disclaimers.

Results

The experiment was successful in automating the entire process of creating blog content. With this system, I could produce and publish many articles with very little manual effort. The templates integrated effectively, and the database facilitated smooth transitions between tasks.

One challenge was ensuring that the AI-generated content met AdSense quality standards. I tried to apply for Google AdSense with the blog created through this system, but my application was rejected due to non-compliance with their "content policy." This is a common issue with AI-generated content, as quality standards can be difficult to meet consistently.

Although I set up multiple ChatGPT accounts to run automatically, I had to continue making adjustments over time to avoid account blocks or limits due to overuse.

This case study explains how I used ZennoPoster templates and tools like ChatGPT to automate content creation. The experiment highlighted both the strengths of automation and the limitations of AI in generating quality content.

To ensure all templates worked seamlessly together, I used a MySQL database to manage the workflow. The database served as a central point to store critical information, such as which articles were completed, which accounts were active, and which posts had been published. This setup allowed the templates to work together smoothly, preventing task repetition or missed steps.

I also implemented a logging system to record all actions performed by each template, which allowed me to monitor progress and address any issues. This log was crucial for troubleshooting, especially when switching between different ChatGPT accounts or publishing articles on Blogger.

To accomplish this, I used four main templates:

Google News Template: Parsing Top Stories

The first step was collecting relevant information. I developed a specialized template to gather top news stories from Google News in specific categories, such as technology, business, and sports. This template extracted the titles, summaries, and links for each article. The data was saved into subfolders organized by category, with each story stored in a database where its ID was hashed using SHA256. Related images were downloaded and stored in an "images" folder.

Article Extractor Template

After collecting the news articles, I needed to clean up their content for further processing. Parsing articles can be challenging due to the diverse layouts and structures of different websites. To simplify this, I used browser extensions like Just Read to remove unnecessary elements, leaving only the main article.

The template extracted only the text from each article, discarding extra elements like ads, images, and menus. Article metadata was stored in the database, and each article ID was converted into a SHA256 hash to simplify tracking. This process helped identify duplicate stories; if an article ID already existed in the system, it meant that the story had already been parsed. This method saved time and avoided redundancy.

ChatGPT Template: Managing Multiple Accounts

To create unique content for the blog, I used ChatGPT. However, given the usage limits, I needed multiple accounts to generate sufficient content for my project. So, I built a template to help manage and switch between over 60 free ChatGPT accounts.

The template automatically logged into ChatGPT accounts to generate content from the gathered articles. If a session ended or hit a usage limit, the system would switch to another account and continue generating content. Managing multiple accounts and automating logins was easy. Using different profiles allowed quick switching between accounts, which helped avoid delays in content creation.

Blogger Template

After ChatGPT created the content, the next step was to automatically post the articles on Blogger. The Blogger template took the content generated by ChatGPT, edited it to remove unnecessary elements, and posted it. It also added any required images and ensured the post looked good.

During the posting process, the template automatically refined ChatGPT’s output to make it more blog-friendly by removing any unnecessary instructions or disclaimers.

Results

The experiment was successful in automating the entire process of creating blog content. With this system, I could produce and publish many articles with very little manual effort. The templates integrated effectively, and the database facilitated smooth transitions between tasks.

One challenge was ensuring that the AI-generated content met AdSense quality standards. I tried to apply for Google AdSense with the blog created through this system, but my application was rejected due to non-compliance with their "content policy." This is a common issue with AI-generated content, as quality standards can be difficult to meet consistently.

Although I set up multiple ChatGPT accounts to run automatically, I had to continue making adjustments over time to avoid account blocks or limits due to overuse.

Последнее редактирование модератором: