- Регистрация

- 26.09.2019

- Сообщения

- 394

- Благодарностей

- 73

- Баллы

- 28

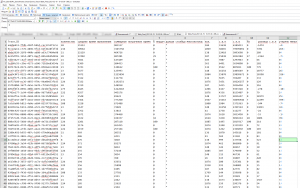

Друзья, проблема в следующем, есть парсер, на гет запросах, без браузера. По сути, он просто парсит DOM страницы и дальше regex'ами достает нужную информацию, какого то особенного доп кода нету, но достаточно много regex'ов. около 120. Единственная вещь, что если запускать в ПМ, то порой если какой-то инфы нету на сайте, то этот regex довольно долго прогружает. В конце все записывается в таблицу на компьютере.

Вопрос, 10 потоков работают лучше, чем 40. Компьютер вывозит, загрузка 40% максимум. В чем может быть проблема? Спасибо. Зенка последняя.

Вопрос, 10 потоков работают лучше, чем 40. Компьютер вывозит, загрузка 40% максимум. В чем может быть проблема? Спасибо. Зенка последняя.

.

.